Muito se fala do futuro automóvel, dos carros elétricos, dos carros smart, e claro… Dos carros completamente autónomos, que não irão precisar do input de ninguém para levar os agora condutores do ponto A para o ponto B. Mas faz ideia do que isto significa? O carro vai ter de tomar decisões difíceis… Muito difíceis…

(Especial) Já pensou no dilema ético dos carros autónomos?

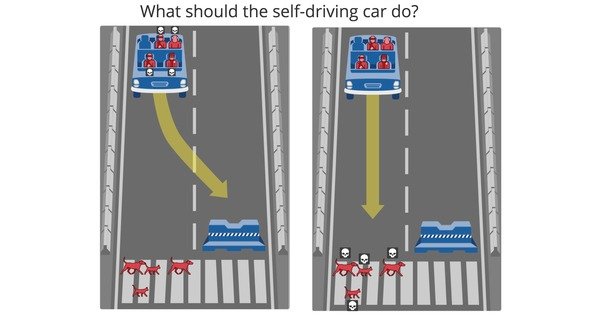

Portanto, antes dos carros autónomos serem uma realidade, é preciso ter uma solução para o problema ético que esta inevitabilidade traz para cima da mesa. Afinal de contas, se um computador decide quem morre, vai ser o condutor ou o peão?

Portanto, antes dos carros autónomos serem uma realidade, é preciso ter uma solução para o problema ético que esta inevitabilidade traz para cima da mesa. Afinal de contas, se um computador decide quem morre, vai ser o condutor ou o peão?

Ou seja, se não é possível evitar uma colisão, o que irá o computador escolher?

Isto tem de ser programado, e tem de ser decidido antes da coisa se tornar uma realidade do nosso dia-a-dia.

É aceitável um carro autónomo defender o ‘condutor’ se isso significa atropelar um peão? Ou será que é mais aceitável fazer o contrário? Ou seja, meter o condutor em risco ao mesmo tempo que se salva o peão?

Os consumidores vão comprar um carro que irá preferir proteger os outros em vez de si mesmo? Ou os peões vão sentir-se seguros na rua ao saber que os carros vão sempre preferir proteger o condutor em seu detrimento?

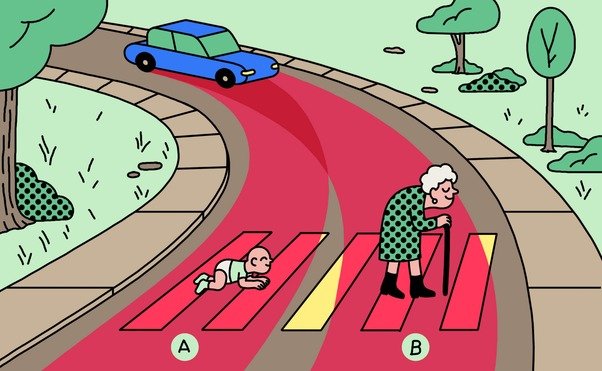

Por exemplo, se uma colisão for inevitável, quem irá o carro escolher?

Não é uma decisão fácil pois não? E esta escolha em baixo com animais à mistura?

Será que irá estar programado para proteger os animais e meter o condutor em risco, ou vai simplesmente ignorar e atropelar os animais?

As pessoas querem sempre mais e mais evolução tecnológica. Mas será que queremos mesmo dar assim tanto poder de decisão a uma máquina?

Ademais, o que pensa sobre tudo isto? Partilhe connosco a sua opinião nos comentários em baixo.

Receba as notícias Leak no seu e-mail. Carregue aqui para se registar. É grátis!